【本站】6月13日消息,近日,阿联酋科技创新研究所(TII)成功研发出了一款具有里程碑意义的语言模型Falcon-40B,该模型在Hugging Face的OpenLLM排行榜上名列第一,并一直保持领先地位,胜过了LLaMA、StableLM和RedPajama等竞争对手。

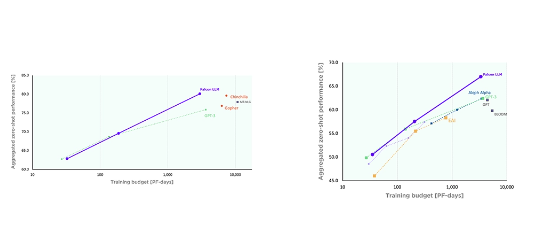

据悉,Falcon-40B语言模型是利用384颗GPU进行为期两个月的训练,并利用近5亿个Token进行训练而成。为了提高训练质量,研究团队自行构建了一套工作流程,筛选出高质量的数据,供AI模型进行训练。经过多个基准测试,该模型在性能上表现出色,超过了LLaMA、Vicuna和Alpaca等模型。

此外,团队还引入了“多重查询注意力”机制,以提高模型的效率。该机制允许模型对每个Token进行多次查询,从而更好地表示同一序列中不同Token之间的关系。这样一来,模型在加速计算效率的同时降低了复杂性,进而提升了整体的可维护性。

阿联酋科技创新研究所首席执行官Ray O. Johnson博士表示:“2023年将是人工智能之年。Falcon模型对我们来说具有里程碑意义,但这只是个开始。”

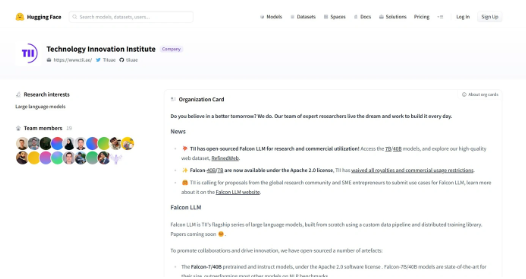

据本站了解,Falcon模型已在Hugging Face平台上开源,目前已有Falcon-7B-Instruct和Falcon-40B-Instruct等版本可供使用。这一突破将进一步推动人工智能领域的发展,并为相关领域的研究和创新提供有力支持。